Le guide complet de l’A/B testing pour le Google Play Store

Conseils promotion d'apps mobiles

février 14, 2018

Il y a deux objectifs principaux à atteindre lorsque vous ajoutez une vidéo promo sur votre fiche Play Store.

Le premier est d’augmenter votre conversion sur la page de l’app, c’est à dire d’avoir plus d’installations pour le même nombre de visiteurs de votre fiche. Une vidéo bien faite, qui montre le sujet de l’app/du jeu et de quelle manière celle-ci/celui-ci apporte quelque chose en plus devrait convaincre plus facilement l’utilisateur potentiel de télécharger l’app.

Le second est d’augmenter l’interaction et le taux de rétention après l’installation. Un nouvel utilisateur qui a regardé la vidéo avant de la télécharger a une meilleure idée de ce que l’app/le jeu peut lui apporter et est plus susceptible de s’y retrouver ou de continuer à jouer.

- À quel impact peut-on s’attendre sur le taux de conversion ?

- Introducing Google Play Store listing experiments

- Avant d’aller plus loin

- Étape 1 : Chargez votre vidéo promo sur YouTube

- Étape 2 : Créez votre test

- Étape 3 : Ne regardez pas ce qu’il se passe !

- Étape 4 : Analysez les résultats

- Étape 5 (optionnelle) : l’analyse avant/après du taux de conversion

- Étape 6 (optionnelle) : Réalisez un test B/A (contre-test)

- Étape 7 (optionnelle) : Ajustez/optimisez votre vidéo promo

- Mesurer l’impact sur la rétention

- Conclusion

Êtes-vous en train de réaliser une vidéo ou vous venez d’en créer une avec nous ?

Vous vous demandez peut-être comment évaluer l’impact de votre vidéo promo sur Play Store. Comment savoir si la vidéo est utile ?

Vous souhaitez discuter d’un projet pour une vidéo Google Play Store ? Jetez un coup d’oeil à nos services d’app vidéo et contactez-nous pour recevoir une proposition gratuite et personnalisée. Vous travaillez déjà avec nous ? Si quelque chose n’est pas clair ou que vous souhaitez simplement échanger à ce sujet (gratuitement), il vous suffit de joindre votre manager de projet chez Apptamin et un membre de notre équipe sera heureux de discuter avec vous.

Voici un guide étape par étape, de nos conseils pour mesurer l’impact d’une vidéo promo.

Remarque : UN GRAND NOMBRE des conseils présents dans cet article sont généraux et s’appliquent aux tests pour les attributs d’autres fiches (l’icône, les captures d’écran, etc.) ou même à d’autres tests A/B. Mais nous nous concentrons ici particulièrement sur les Tests pour les fiches Play Store pour les attributs vidéo.

À quel impact peut-on s’attendre sur le taux de conversion ?

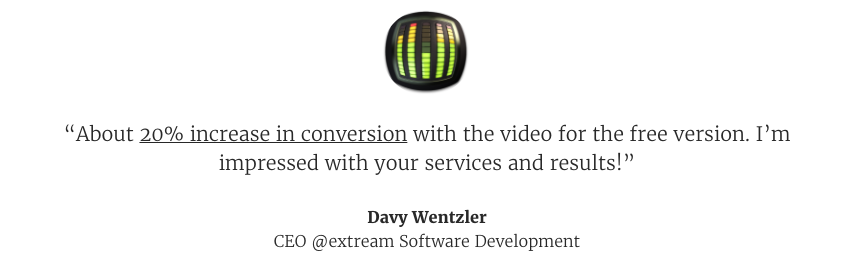

Beaucoup de nos clients ont vu leur taux de conversion augmenter après avoir ajouté une nouvelle vidéo.

Parfois, ils avaient déjà une vidéo sur Play Store, et parfois ils n’en utilisaient pas encore.

Une introduction aux Tests pour les fiches Play Store

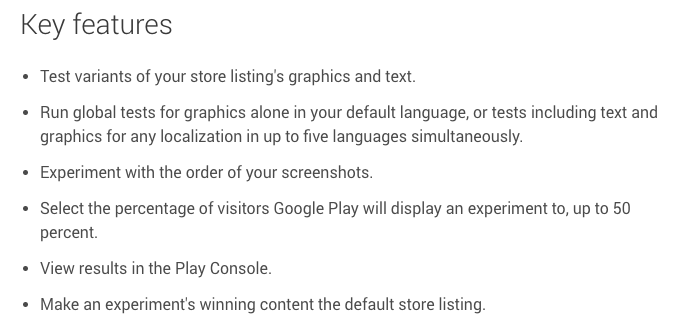

Google propose un outil dans la console développeur Google Play appelé Tests pour les fiches Play Store.

Avec cet outil vous pouvez effectuer des tests A/B et appliquer les changements à votre fiche Google Play : un sous-groupe de visiteurs du Play Store verront la version A, et un autre la version B. Vous pouvez ensuite comparer et voir laquelle des versions a obtenu le plus d’installations.

Avant d’aller plus loin

Avec quelle(s) localisation(s) commencer ?

Pouvoir localiser les vidéos sur Play Store est formidable.

Si une partie importante de vos utilisateurs parle une autre langue, adapter votre vidéo sur mesure pour eux.

Avec les Test pour les fiches Play Store, vous pouvez effectuer des tests pour n’importe quelle localisation, jusqu’à dans cinq langues en même temps.

Ceci dit, à moins que vous n’ayez un volume de téléchargements important, vous devriez commencer par effectuer le test A/B dans une seule langue à la fois (par exemple: EN-US).

Déterminez vos objectifs

Dans le cas où vous n’avez pas encore de vidéo sur votre fiche Play Store, vous effectuerez dans un premier temps les tests A/B ainsi :

- Version A (la version actuelle) : pas de vidéo

- Version B (la variante avec une vidéo) : la fiche est semblable en tous points, mais elle a une vidéo promo

Si vous avez déjà une vidéo promo sur votre fiche, vous effectuerez dans un premier temps les tests A/B ainsi :

- Version A (Version actuelle) : la vidéo actuelle

- Version B (Variante avec vidéo) : une nouvelle vidéo

Après avoir effectué votre test, l’objectif est de déterminer si la vidéo a contribué à convertir davantage de visites en installations sur le Google Play Store, et de combien.

Avant de commencer, il vous faut donc définir :

- La variable : le seul élément à être modifié (une vidéo vs. pas de vidéo, une nouvelle vidéo vs. la vidéo actuelle)

- Le résultat : l’issue attendue (de combien pensez-vous que cela modifiera le taux de conversion)

- La logique : pourquoi pensez-vous que cela devrait modifier le taux de conversion

Essayez de maintenir des efforts de marketing/d’acquisition relativement stables

Les tests mesurent ce qu’il se passe uniquement dans le Play Store. Mais beaucoup de facteurs externes peuvent affecter les résultats.

Les principaux que nous avons identifiés (tant que votre fiche Play Store reste la même) sont des grandes campagnes de marketing ou de promotion. S’il y a de grands changements dans celles-ci, vous risquez d’obtenir des comportements différents de la part des visiteurs de votre fiche Google Play : ils peuvent avoir déjà pris la décision de télécharger l’app en s’y rendant par exemple.

Et puisque Google ne fait pas la différence entre les types d’installation (suite à une recherche sur Google Play Store, à une navigation, via un référenceur tiers comme les réseaux publicitaires, etc.) cela modifie la « combinaison habituelle des sources » pour les visiteurs, ce qui peut avoir un impact sur les changements/les tests que vous effectuez (y compris la vidéo). Et ce d’autant plus s’ils ont déjà vu une vidéo de promotion et sont déjà renseignés sur ce que l’app peut leur apporter !

Nous comprenons qu’il n’est pas toujours possible de ne pas faire varier les efforts marketing/de publicité pendant un temps donné, mais gardez au moins cela à l’esprit.

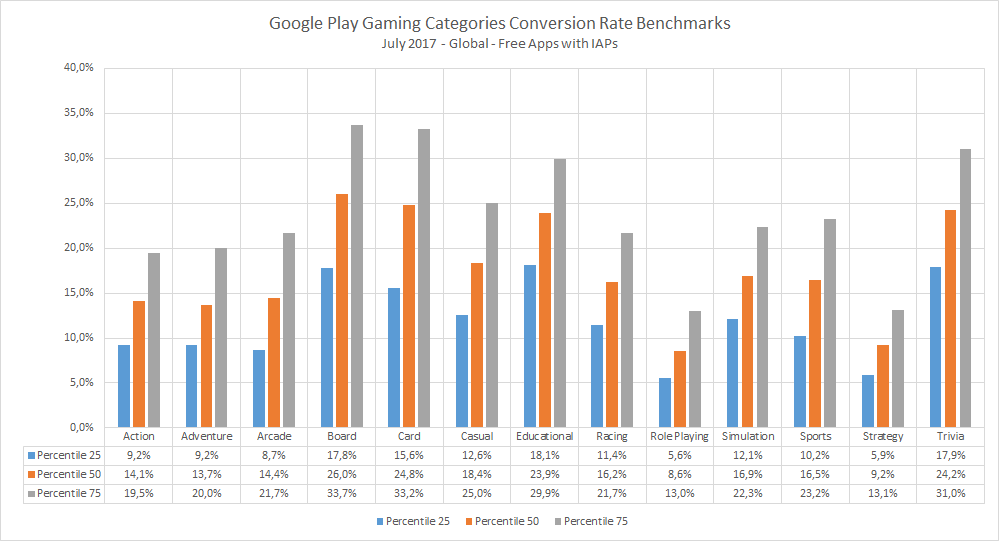

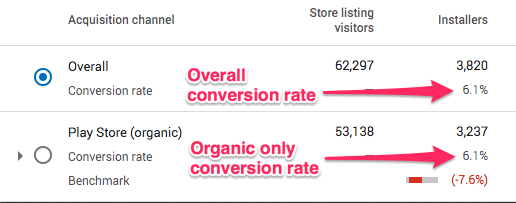

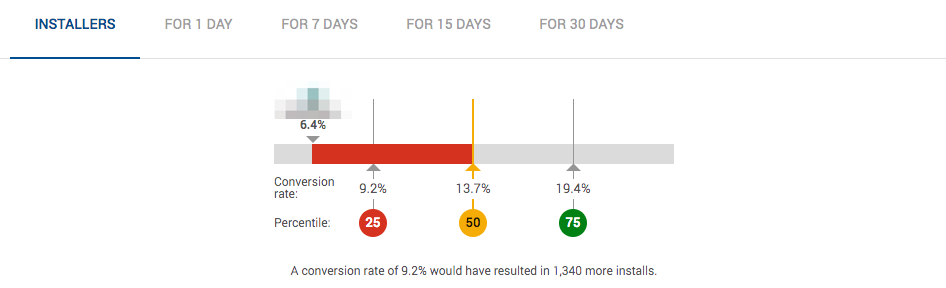

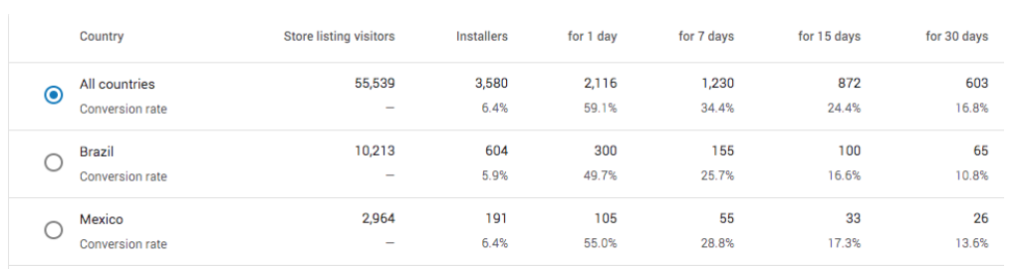

Quel est votre taux actuel de conversion ?

Dans le cas de votre app, ces taux de conversion sont disponibles dans vos rapports d’acquisition sur votre console développeur Google Play.

Voici à quoi ils ressemblent :

Vous pouvez trouver les taux de conversion généraux et ceux liés à une recherche sur Google Play Store, pour tous les pays, dans votre rapport lorsque vous mesurez « par canal d’acquisition »

Notez chaque taux de conversion de la semaine précédente. Vous pouvez aussi noter les taux de conversion généraux et ceux liés à une recherche sur Google Play Store concernant le pays pour lequel vous souhaitez effectuer les tests (dans notre cas, les États-Unis puisque nous avons choisi la langue EN-US).

Vous allez effectuer un test A/B, mais il vaut mieux tout de même savoir quels sont vos taux de conversion avant, pendant et après ce test (voir aussi l’Étape 5).

De quel volume de téléchargements (et de quelle taille d’échantillon) avez-vous besoin ?

Pour votre test, vous avez besoin d’une taille d’échantillon suffisamment grande pour que Google puisse établir une pertinence statistique (et définir une version « gagnante »).

La plupart des gens vous diront qu’il vous faudra quelques milliers d’installations pour chaque version si vous voulez avoir des résultats fiables.

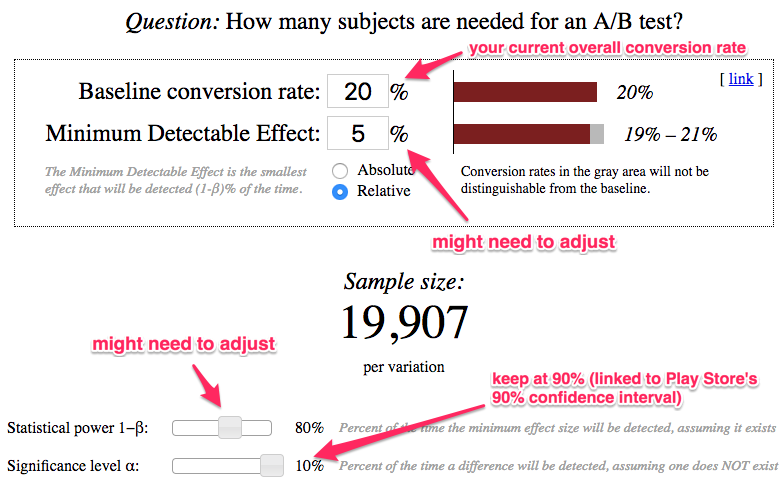

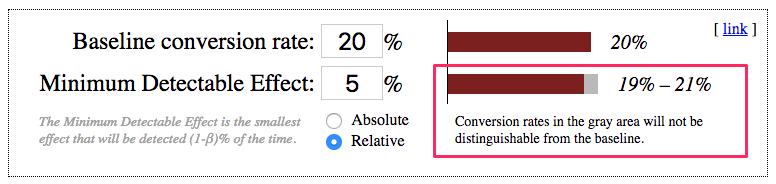

Pour vous aider à déterminer la taille de votre échantillon, jetez un oeil à ce Calculateur de taille d’échantillon très pratique. Voici un exemple des paramètres que vous pouvez utiliser :

Important : les paramètres indiqués comme « à ajuster » peuvent varier selon votre cas (voir l’explication ci-dessous).

Certains des paramètres à définir pour votre taille d’échantillon sont fixes (le seuil de signification : 10%) ou plutôt évidents (votre taux de conversion).

D’autres, en revanche, peuvent varier en fonction de la précision dont vous avez besoin vis-à-vis des changements effectués :

- l’effet décelable minimal (EDM)

- la significativité statistique

Si vous venez de vous lancer ou si vous êtes une start-up avec quelques téléchargements et que vous êtes prêts à prendre plus de risques, vous pouvez avoir des paramètres moins stricts concernant l’EDM et la significativité statistique. Mais ce que nous avons sur l’image ci-dessus correspond à des valeurs plutôt « normales » (EDM : 5%, significativité statistique : 80%).

Si vous avez une app à succès qui est publiée depuis un moment et qui est dans le haut du classement, effectuez un test plus précis avec des paramètres plus stricts. Vous pouvez par exemple baisser l’EMD et augmenter la significativité statistique. La taille d’échantillon dont vous avez besoin sera plus élevée mais vos résultats plus précis.

Dans l’exemple ci-dessus, vous avez besoin d’au moins 19907 visiteurs pour chaque variante, soit 39814 au total. Si votre taux de conversion est actuellement de 20% comme ici, cela signifie qu’il vous faudra 1962,8 téléchargements au total (ou 3981 par variante, avec seulement 2 variantes comme nous l’avons dit).

Si vous lancez un test sans attendre d’avoir le volume de téléchargements, les résultats ont peu de chances d’être précis. Maintenant voyons de combien de temps vous avez besoin pour votre test.

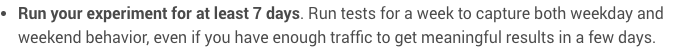

Combien de temps doit durer le test pour votre fiche Google Play Store ?

Bien entendu, la réponse à cette question est liée au volume d’installations nécessaire que vous avez défini plus haut.

Comme nous l’avons vu, nous avons besoin d’un volume de 4000 installations (en arrondissant les 3981 plus haut) par variante. Disons 5000 installations par semaine, et vous aurez donc :

- pour un test d’1 semaine : 2500 installations pour chaque version. C’est insuffisant.

- pour 2 test de 2 semaines : 5000 installations pour chaque version. Cela devrait donner des résultats plus fiables.

Donc si vous obtenez 30k de téléchargements par semaine, devriez-vous pour autant réaliser un test sur 2 jours ?

La réponse est non. Le comportement des visiteurs du Play Store peut varier au cours de la semaine ou pendant le week-end et nous vous recommandons de faire durer votre test au moins une semaine entière.

Une fois que vous avez réglé la taille de votre échantillon et donc le temps que durera votre test, tenez-vous y (voir Étape 3).

Pourquoi vous ne devez PAS tester plus de deux versions en même temps

L’outil Tests pour les fiches Play Store vous permet de faire davantage que des tests A/B : vous pouvez réaliser des “split tests” sur un maximum 4 versions (la version en cours + les 3 variantes) en même temps.

Nous vous recommandons (et nous ne sommes pas les seuls) de ne tester que 2 versions (la version en cours + 1 variante). Il ne s’agit pas uniquement d’obtenir les résultats (plus stables) plus rapidement, cela facilite également l’analyse.

Comme l’explique Luca Giacomel de Bending Spoons, « la vraie raison pour ne pas réaliser plusieurs tests A/B en parallèle est que tous ces tests produiront une fiabilité statistique moindre du fait d’un problème statistique très connu, appelé « les comparaisons multiples » ou « l’effet du regarde ailleurs » (“look elsewhere effect”).

Donc…. Faites-nous confiance. Ne compliquez pas excessivement les choses

Étape 1 : Chargez votre vidéo promo sur YouTube

Une vidéo Google Play Store est une vidéo YouTube.

Pour être en mesure d’ajouter une vidéo promo à votre fiche Play Store, il vous faut donc d’abord la charger sur YouTube.

Comme vous le savez, YouTube propose 3 options pour ses vidéos : publique, privée et non-répertoriée. Vous ne pouvez pas utiliser le mode privé pour des raisons évidentes, penchons-nous donc sur les deux autres.

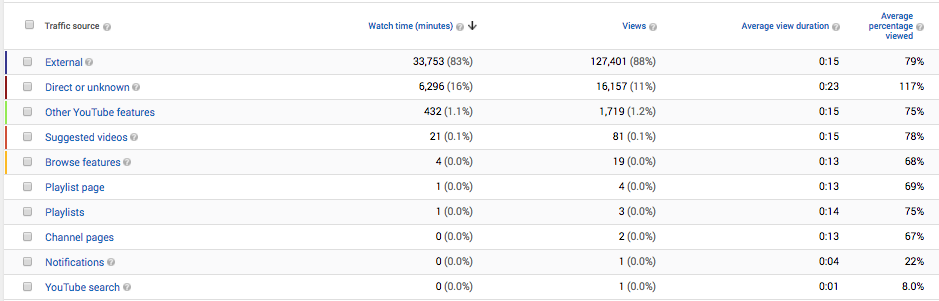

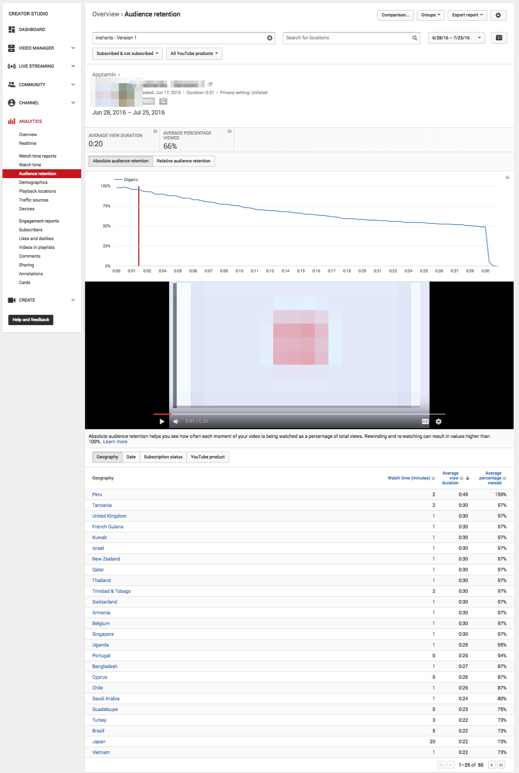

L’avantage d’une vidéo non-répertoriée est que vous savez que la majeure partie de vos vues (souvent > 90%) proviennent de personnes ayant vu la vidéo sur le Google Play Store. Vos données YouTube Analytics ont plus de sens et vous permettent d’avoir un aperçu du comportement et de l’interaction des utilisateurs vis-à-vis de votre/vos vidéo(s) sur le Google Play Store.

Lorsqu’une vidéo est non-répertoriée, la plupart de ses vues proviennent du Google Play Store (« externe »)

Si la vidéo est en mode public, vous avez quand même la possibilité de voir les sources de trafic. Mais vous ne pourrez pas analyser les métriques de la vidéo par source (vous trouverez plus d’informations à ce sujet dans la dernière partie de cet article).

L’avantage d’une vidéo en mode public est que si la fiche de votre app obtient beaucoup de trafic, votre vidéo peut rapidement avoir des milliers de vues, qui lui permettent de monter dans les résultats de recherche sur YouTube (le deuxième moteur de recherche après Google). Ou même sur Google.

Dans la plupart des cas, nous vous conseillons de commencer avec votre/vos vidéo(s) en mode non répertoriée, au moins jusqu’à ce que vous soyez certains qu’elle restera un moment (c’est-à-dire si vous n’allez pas optimiser/tester la partie vidéo pendant un moment).

Étape 2 : Créez votre test

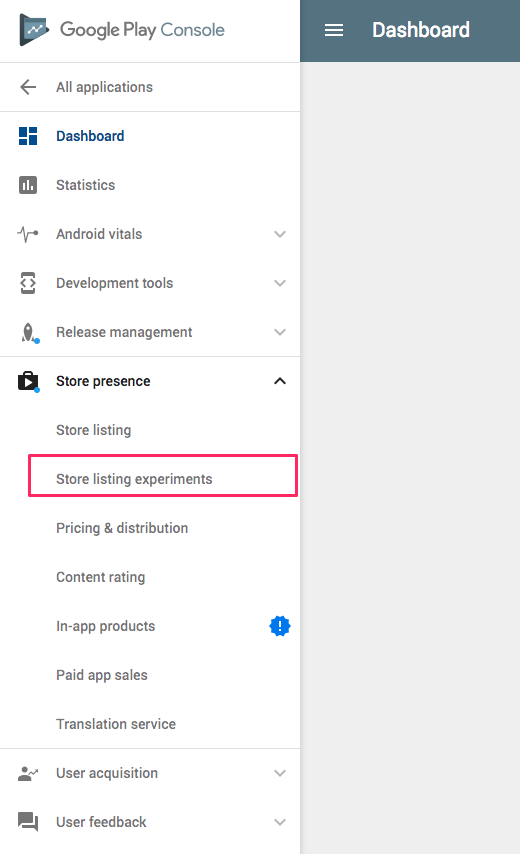

Ouvrez votre console développeur Google Play, cliquez sur la section « Tests pour les fiches Play Store » dans « Présence sur le Play Store ».

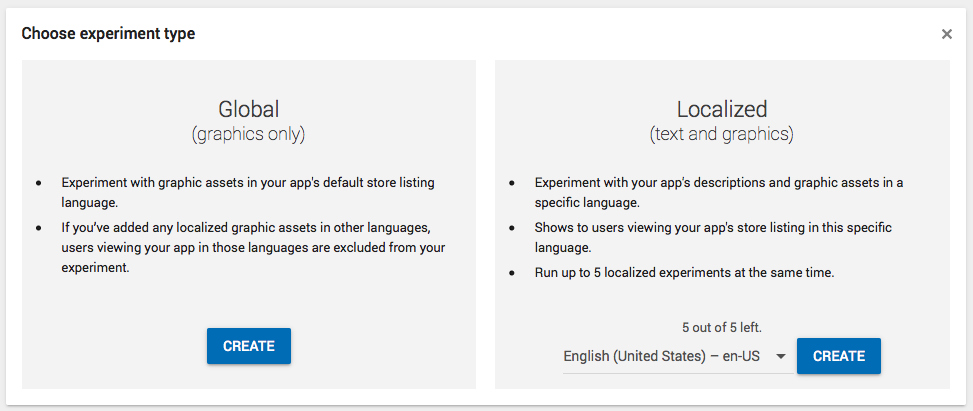

Cliquez sur « Nouveau test » puis sélectionnez la langue désirée dans la section « Localisé ».

Cliquez sur « Nouveau test » puis sélectionnez la langue désirée dans la section « Localisé ».

La raison pour laquelle vous sélectionnez la langue dans « Localisé » est qu’il vous faut effectuer un test uniquement sur les utilisateurs parlant la langue de votre vidéo, afin que le comportement des autres utilisateurs n’affecte pas les résultats.

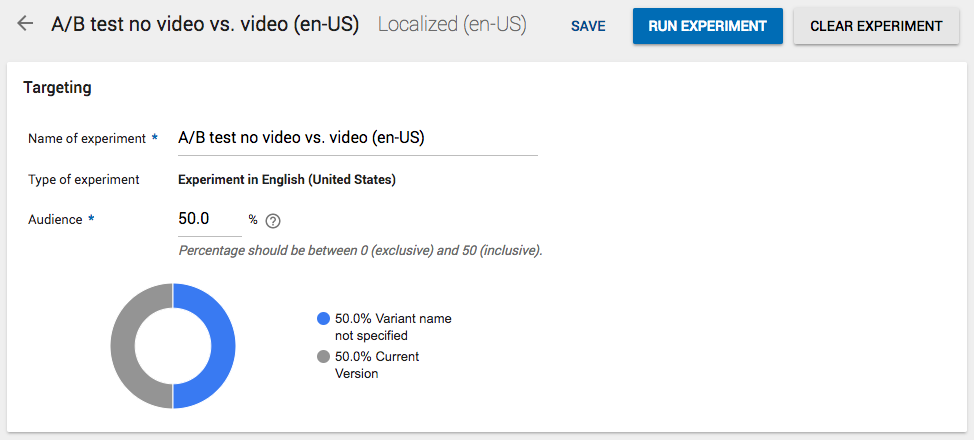

Créez le test en lui donnant un nom et en choisissant quel pourcentage du public le verra. Choisissez le maximum autorisé de 50%.

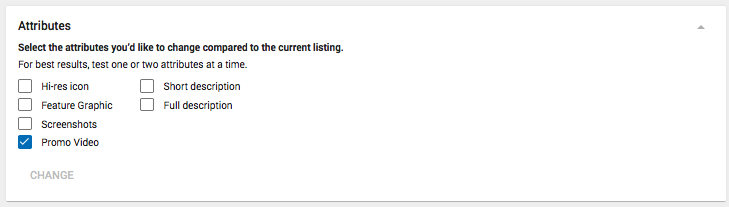

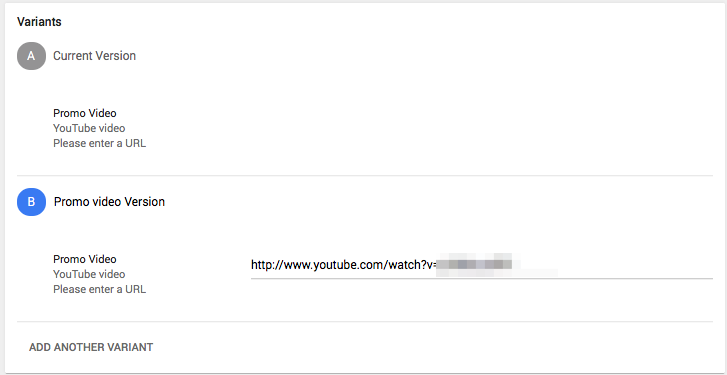

Sélectionnez ensuite ce que vous voudriez changer par rapport à votre fiche actuelle. Ici, sélectionnez seulement « Vidéo promo ».

Nommer votre Variante (par exemple : Vidéo) et copiez le lien URL de YouTube de votre vidéo.

Et voilà !

Vous pouvez maintenant lancer le test (mais continuez à lire cet article).

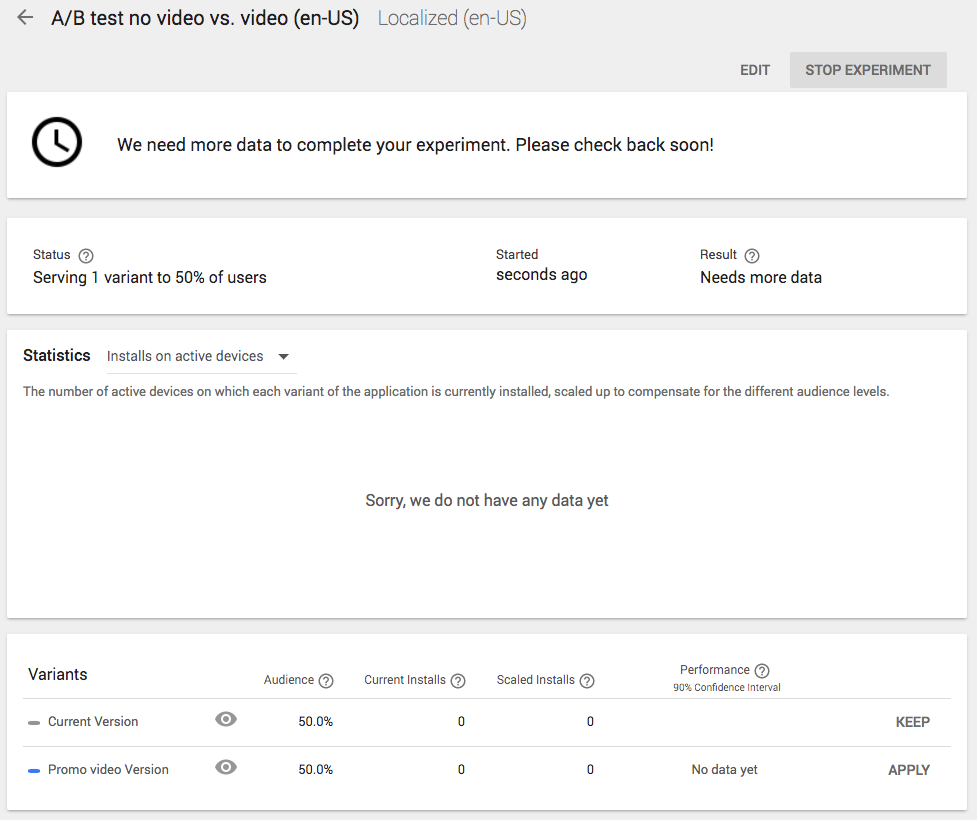

Étape 3 : Ne regardez pas ce qu’il se passe !

C’est la partie la plus difficile.

Votre test est en cours et il est très tentant de venir le surveiller tous les jours afin de savoir quelle variante a la meilleure performance.

Observer les données ne modifiera pas les résultats à proprement parler mais est-ce que vous vous faites confiance dans le cas où le test ne se déroule pas aussi bien que prévu (ou vraiment mal) ? Aurez-vous le courage de le laisser se poursuivre ?

Il est préférable de vous en tenir à la période de test que vous avez établie, et de rester à l’écart de ce fichu test. Même si Google vous dit qu’il est terminé.

Pourquoi ?

Très brièvement : à cause des faux positifs (“false positive”). Vous pourriez penser (et Google pourrait vous dire) que le test est un succès mais comme vous n’avez pas atteint la taille de votre échantillon, cela pourrait en fait ne pas être le cas.

Pour entrer dans les détails : si vous voulez vraiment savoir pourquoi, consultez cet article afin de comprendre ce que sont les seuils de signification et les faux positifs.

Étape 4 : Analysez les résultats

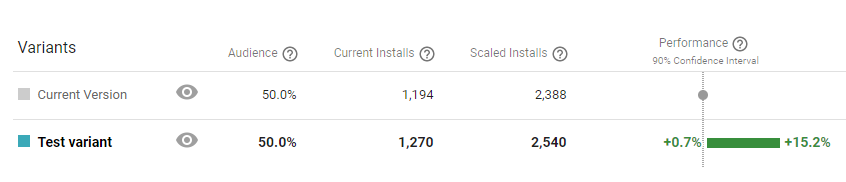

Bon, la durée du test est achevée et la taille d’échantillon a été atteinte. C’est le moment de voir si la variante a été plus performante.

“Current installs” correspond au nombre d’installations réelles pour chaque version. “Scaled Installs” correspond à ce que vous auriez obtenu pour une seule des versions. Ici, c’est le double parce que nous travaillons sur une division en 50-50.

Si Google vous indique une version gagnante

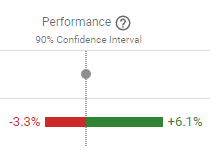

La performance de la variante n’est pas totalement positive

Si vous deviez refaire le test 10000 fois, vous obtiendriez 90% des fois un résultat qui se situerait dans un éventail de -3.3%-6.1%.

→ N’APPLIQUEZ PAS LE CHANGEMENT

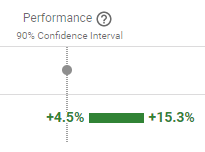

La performance de la variante est totalement positive (>0)

Si vous refaisiez le test 10000 fois, vous obtiendriez 90% des fois un résultat qui se situerait dans un éventail de +4.5%-15.3%

Ce qui signifie également que pour le 10% des fois restant vous obtiendriez un résultat qui pourrait ne pas se situer dans cet éventail.

→ APPLIQUEZ LE CHANGEMENT

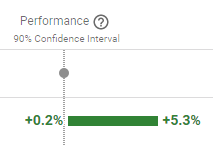

Remarque : vous vous souvenez du paramètre pour l’Effet Décelable Minimal (EMD) que vous avez choisi au début ?

Comme cela affecte la taille de la « zone grise », si l’EMD est grand, soyez vigilants au moment d’appliquer un changement qui a donné un éventail de résultats trop proche de 0 (même s’il est positif).

Comme cela affecte la taille de la « zone grise », si l’EMD est grand, soyez vigilants au moment d’appliquer un changement qui a donné un éventail de résultats trop proche de 0 (même s’il est positif).

Si vous obtenez ce type d’éventail, vous pouvez être moins certains de vos résultats, surtout si votre EMD est de 5% ou plus.

Si Google vous indique qu’il faut plus de données

Ici aussi, attention : Google prétend souvent qu’il y a suffisamment de données au bout de 2 ou 3 jours, puis change d’avis et revient à « il faut plus de données », d’où l’importance de définir la taille d’échantillon avant le test (et de suivre l’Étape 3 !).

Si Google vous dit que le test n’est pas terminé car il faut plus de données après que la taille d’échantillon ait été atteinte, considérez que le test n’est pas concluant pour l’instant.

→ N’APPLIQUEZ PAS LE CHANGEMENT

Remarque : si la taille d’échantillon n’a pas encore été atteinte et que Google indique qu’il faut plus de données, cela signifie sans doute que vous n’avez pas lu l’Étape 3. Attendez donc que la taille d’échantillon soit atteinte et laissez le test se faire.

Étape 5 (optionnelle) : l’analyse avant/après du taux de conversion

Nous avons évoqué au début la référence du taux de conversion que Google vous donne, vous savez donc où vous en êtes et de combien vous pourriez l’améliorer par rapport aux autres apps de la même catégorie.

Afin de valider les résultats de votre test A/B de manière plus approfondie et de constater ce qu’il se passe réellement une fois que le changement est appliqué, surveillez le pourcentage du taux de conversion pendant une semaine avant le test et comparez-le à celui de la semaine suivant la fin du test.

Pour faire cela, vous devez vous abstenir de lancer un autre test pendant ce temps.

Le taux de conversion dans la référence de conversion n’est valable que pour les visiteurs du Play Store (ceux qui y naviguent directement) et inclut toutes les localisations/tous les pays.

Si vous choisissez de mener un test localisé comme nous vous l’avons suggéré, surveillez plutôt le taux de conversion correspondant au pays/à la langue.

Il va sans dire que ce que vous voulez constater (pour tous les pays, mais aussi pour les pays et les langues ciblés) est le résultat ci-après :

Taux général de conversion avant le test > taux général de conversion après le test

Taux de conversion par navigation directe avant le test > taux de conversion par navigation directe après le test

Si ce n’est pas ce que vous observez, consultez les paramètres/la taille de l’échantillon que vous avez choisi(s) et les résultats du test A/B. Réalisez à nouveau le même test ou envisagez de faire un test B/A.

Étape 6 (optionnelle) : Réalisez un test B/A (contre-test)

Comme nous l’avons vu plus haut, vous ne devez appliquer le changement que si l’augmentation est importante.

Thomas Petit (mobile growth chez 8fit) prévient que la méthode de test B/A décrite ci-dessous n’est pas valide d’un point de vue purement statistique, mais peut permettre d’éviter les erreurs les plus grandes. Il le recommande donc malgré tout. Jetez un coup d’oeil à sa présentation et à ses slides sur le test A/B pour votre fiche Play Store.

Pour réaliser un test B/A il vous faut inverser les versions :

- Version A (la version actuelle) : une vidéo promo sur la fiche

- Version B (la variante sans vidéo) : exactement la même fiche, mais sans vidéo

Lancez le test exactement de la même manière. Si vous obtenez le même type de performance, vous pourrez considérer que la fiabilité des résultats est plus élevée.

Étape 7 (optionnelle) : Ajustez/optimisez votre vidéo promo

Il est possible d’améliorer votre vidéo. Bien sûr, c’est d’autant plus vrai si les résultats du test ne sont pas positifs.

Analysez les informations de votre YouTube Analytics

Bien que vous ne puissiez pas (encore ?) savoir qui a visionné votre vidéo parmi les visiteurs ayant installé l’app, jeter un coup d’oeil aux indicateurs dans YouTube Analytics peut vous donner une idée de l’interaction qu’elle engendre.

Voici les informations que vous devez regarder :

- le nombre de vues

- la durée moyenne de visionnage

- le pourcentage moyen de visionnage

Le graphique de la « Rétention d’audience » est intéressant à observer : il identifie à quelle vitesse vous « perdez » ceux qui visionnent la vidéo.

Si vous constatez une chute soudaine, essayez de réfléchir à la manière dont vous pourriez ajuster la vidéo afin de contrer le phénomène.

Remarque : vous pouvez faire la même chose avec les vidéos YouTube que vous utilisez pour vos campagnes universelles de promotion d’app.

Ce que vous pouvez tester/h3>

Quels types d’ajustements pouvez-vous effectuer pour optimiser la vidéo ?

Tout d’abord, faites un résumé de sa structure. Quelque chose comme :

- 2s téléphone animé avec le logo, l’icône et le slogan

- 5s sur la proposition de valeur 1

- 5s sur la proposition de valeur 2

- 3/4s CTA

Dans l’exemple ci-dessus, l’une des premières choses que vous pouvez essayer est d’enlever complètement le logo au début : votre marque est déjà visible sur la fiche Play Store (l’icône,le nom de l’app, etc.).

Vous pouvez aussi tenter de mettre en avant une autre proposition de valeur. Et bien entendu, vous pouvez décider de partir sur un concept totalement différent.

Quelques astuces et meilleures utilisations :

- Optimiser votre vidéo pour les petits écrans – elle sera visionnée sur un appareil mobile, et doit donc être compréhensible même en petit format. Pensez aux appareils avec zoom, etc.

- Mettre l’avantage le plus important / la proposition de valeur plus importante en premier – il n’y a absolument aucune raison de commencer avec quoi que ce soit d’autre. Votre vidéo ne doit pas forcément commencer de la même manière que le parcours de l’utilisateur.

- Faites en sorte que l’on puisse tout comprendre sans le son – beaucoup de visiteurs n’auront pas mis le son, utilisez donc des textes. C’est une vidéo YouTube, mais elle est ici visionnée sur le Play Store et l’utilisateur n’a pas le comportement typique de celui de YouTube.

- Si votre vidéo est en plusieurs langues, assurez-vous qu’elle est localisée

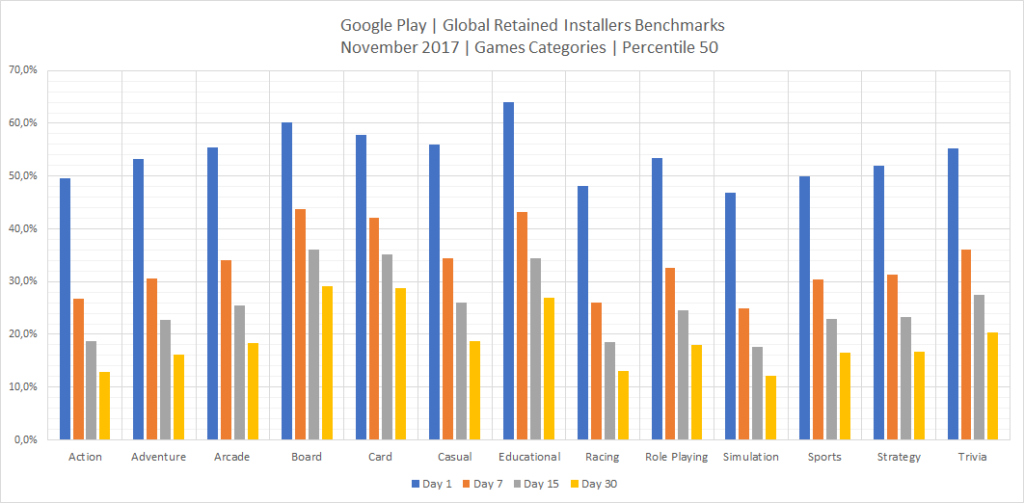

Mesurer l’impact sur la rétention

Pour le second objectif mentionné au début de cet article (augmenter la rétention), les mesures sont assez délicates. La seule option jusqu’à présent semble être de faire une analyse avant/après.

Depuis que Google a ajouté la rétention (Jour 1, Jour 7, Jour 15, Jour 30 – voir les graphiques plus haut), vous pouvez suivre précisément cet indicateur.

Cependant vous ne pouvez pas effectuer des tests A/B sur des cohortes dans la durée et suivre deux groupes d’utilisateurs : ceux pour lesquels la vidéo est visible dans la fiche Play Store et ceux pour lesquels aucune vidéo n’apparaît. La mesure devient par conséquent un véritable défi.

Conclusion

Le but est l’augmentation du taux de conversion de votre vidéo (en obtenant plus d’installations) et/ou de votre taux de rétention (en gardant les utilisateurs plus longtemps).

Les Tests pour les fiches Play Store peuvent vous aider à analyser le premier, et vous devriez en profiter (et pas seulement pour la vidéo !) Lorsque vous effectuez un test sur votre fiche :

- Si vous faites un test localisé, choisissez une seule localisation

- Définissez un seul élément à changer (avec vidéo vs. sans vidéo, nouvelle vidéo vs. vidéo actuelle), le résultat prévu (le % d’amélioration auquel vous vous attendez) et pourquoi

- Maintenez des efforts de marketing/de promotion aussi constants que possible

- Définissez à l’avance votre taille d’échantillon et la durée de votre test

- N’arrêtez pas le test avant que la taille d’échantillon soit atteinte (nous vous conseillons de ne même pas le regarder, même si Google affirme qu’il est terminé)

- Analysez les résultats et appliquez le changement si vous avez une version gagnante

Dans le cas où vous hésitez à faire un test A/B en « live » sur le Google Play Store, vous pouvez aussi regarder comme utiliser un outil tiers de test A/B comme Splitmetrics.

Avez-vous déjà effectué des tests sur Google Play Store ? Partagez vos expériences et ce que vous avez appris dans les commentaires !